Aktywna nauka z SVM

WSTĘP

Wraz z rosnącym zapotrzebowaniem na wyszukiwanie informacji multimedialnych, takich jak pobieranie obrazów i wideo z Internetu, istnieje potrzeba znalezienia sposobów uczenia klasyfikatora, gdy zbiór danych szkoleniowych jest połączony z małą liczbą danych oznaczonych etykietą i dużą liczbą danych nieoznaczonych . Tradycyjne metody uczenia się z nadzorem i bez nadzoru nie nadają się do rozwiązywania takich problemów, szczególnie gdy problem jest związany z danymi w przestrzeni o dużych wymiarach. W ostatnich latach zaproponowano wiele metod, które można ogólnie podzielić na dwie grupy: uczenie się częściowo nadzorowane i uczenie się aktywne (AL). Maszyna wektorów nośnych (SVM) została uznana za skuteczne narzędzie do rozwiązywania problemów wielowymiarowych. Od przełomu wieków wielu badaczy zaproponowało algorytmy aktywnego uczenia się z SVM (ALSVM). Biorąc pod uwagę ich szybki rozwój, w tym rozdziale dokonamy przeglądu najnowocześniejszego rozwiązania ALSVM w rozwiązywaniu problemów klasyfikacyjnych.

TŁO

Ogólne ramy AL można opisać tak.

Krok inicjalizacji: Klasyfikator h jest szkolony na początkowym oznaczonym zbiorze treningowym L

krok 1: Uczeń ocenia każde dane x w potencjalnym zestawie zapytań Q (podzbiór lub cały nieoznakowany zbiór danych U) i wysyła zapytanie do próbki x*, która ma najniższą wartość EvalFun(x, L, h, H) do wyroczni i otrzymuje jej etykietę y*;

krok 2: Uczeń aktualizuje klasyfikator h powiększonym zbiorem uczącym {L + ( x*, y*)};

krok 3: Powtarzaj kroki 1 i 2 aż do zakończenia treningu;

Gdzie

• EvalFun(x, L, h, H): funkcja oceny potencjalnego zapytania x (najlepsza jest tu najniższa wartość)

• L: bieżący oznaczony zestaw treningowy

• H: przestrzeń hipotez

Widać wyraźnie, że jego nazwa - aktywne uczenie się - bierze się z faktu, że uczący się może doskonalić klasyfikator poprzez aktywne wybieranie "optymalnych" danych z potencjalnego zbioru zapytań Q i dodanie go do bieżącego oznaczonego zestawu treningowego L po otrzymaniu jego etykiety podczas procesów. Kluczowym punktem AL są kryteria doboru próby. W przeszłości AL był używany głównie w połączeniu z algorytmem sieci neuronowej i innymi algorytmami uczenia się. Statystyczna AL jest jedną z klasycznych metod, w której próbka minimalizująca wariancję, obciążenie lub błąd uogólnienia jest kierowana do wyroczni. Chociaż metody te mają mocne podstawy teoretyczne, istnieją dwa typowe problemy ograniczające ich zastosowanie: jeden dotyczy sposobu szacowania późniejszego rozkładu próbek, a drugi to zbyt wysoki koszt obliczeń. Aby uporać się z powyższymi dwoma problemami, opracowano szereg metod AL opartych na przestrzeni wersji, które opierają się na założeniu, że funkcję celu można doskonale wyrazić za pomocą jednej hipotezy w przestrzeni wersji i w której próbka może zmniejszyć objętość zaproponowano przestrzeń wersji. Przykładami są zapytania komisji oraz SG AL . Jednak złożoność przestrzeni wersji sprawiła, że były one trudne do rozwiązania, dopóki nie pojawiły się maszyny ALSVM oparte na przestrzeni wersji. Sukces SVM w latach 90. skłonił badaczy do połączenia AL z SVM, aby uporać się z problemami uczenia się z półnadzorem, takimi jak nauczanie na odległość , RETIN oraz wielowidoczność oparte na maszynach ALSVM. W poniższych sekcjach podsumowujemy istniejące dobrze znane maszyny ALSVM w ramach teorii przestrzeni wersji, a następnie krótko opisujemy niektóre strategie mieszane. Na koniec omówimy trendy badawcze dotyczące ALSVM i przedstawimy wnioski .

WERSJA AKTYWNA NAUKA OPARTA NA PRZESTRZENI Z SVM

Ideą prawie wszystkich istniejących heurystycznych maszyn ALSVM jest jawnie lub pośrednio znalezienie próbki, która może zmniejszyć objętość przestrzeni wersji. W tej sekcji najpierw przedstawimy ich podstawy teoretyczne, a następnie dokonamy przeglądu niektórych typowych maszyn ALSVM.

Wersja teorii przestrzeni

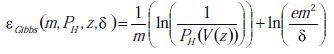

W oparciu o prawidłowy model uczenia się z przybliżeniem prawdopodobieństwa celem uczenia maszynowego jest znalezienie spójnego klasyfikatora, który ma najniższy błąd uogólnienia. Granicę błędu uogólnienia Gibbsa definiuje się jako

gdzie PH oznacza rozkład aprioryczny w przestrzeni hipotez H, V(z) oznacza przestrzeń wersji zbioru treningowego z, m jest liczbą z, a δ jest stałą w [0, 1]. Wynika z tego, że błąd uogólnienia związany ze spójnymi klasyfikatorami jest kontrolowany przez objętość przestrzeni wersji, jeśli rozkład przestrzeni wersji jest równomierny. Zapewnia to teoretyczne uzasadnienie dla maszyn ALSVM opartych na przestrzeni wersji.

Zapytanie złożone przez komisję z SVM

Algorytm ten został zaproponowany, w którym losowo wybrano 2 tys. klasyfikatorów, a próba, w przypadku której te klasyfikatory wykazują maksymalną niezgodność, może w przybliżeniu zmniejszyć o połowę przestrzeń wersji, a następnie zostanie zapytana do Wyroczni. Jednakże złożoność struktury przestrzeni wersji prowadzi do trudności w losowym próbkowaniu w jej obrębie. Z powodzeniem zastosowano algorytm gry w bilard do losowego próbkowania klasyfikatorów w przestrzeni wersji SVM, a eksperymenty wykazały, że jego wydajność była porównywalna z wydajnością standardowego ALSVM opartego na odległości ( SD-ALSVM), który zostanie wprowadzony później. Wadą jest to, że procesy są czasochłonne. Standardowe aktywne nauczanie na odległość z SVM W przypadku SVM przestrzeń wersji można zdefiniować jako:

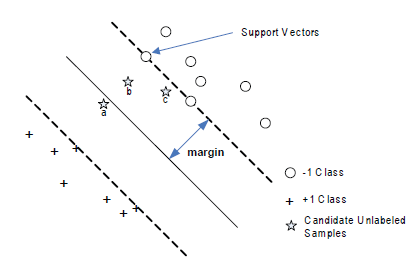

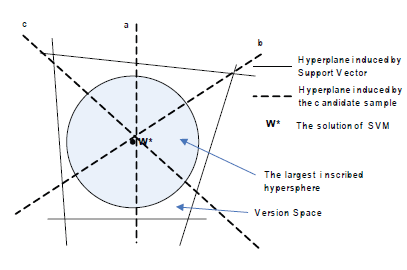

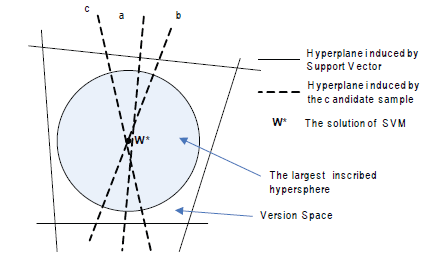

gdzie Φ(.) oznacza funkcję odwzorowującą pierwotną przestrzeń wejściową X na przestrzeń wielowymiarową Φ(X) , a W oznacza przestrzeń parametrów. SVM ma dwie właściwości, które prowadzą do jego podatności na AL. Pierwszą jest jego dwoistość, że każdy punkt w V odpowiada jednej hiperpłaszczyźnie w Φ(X ), która dzieli Φ(X ) na dwie części i odwrotnie. Inną właściwością jest to, że rozwiązanie SVM w* znajduje się w środku przestrzeni wersji, gdy przestrzeń wersji jest symetryczna, lub blisko jej środka, gdy jest asymetryczna. Na podstawie powyższych dwóch właściwości wywnioskowali lemat, że próbka najbliższa granicy decyzyjnej może spowodować, że oczekiwany rozmiar przestrzeni wersji zmniejszy się najszybciej. Zatem próbka najbliższa granicy decyzyjnej zostanie zapytana do wyroczni .

Jest to tak zwana SD-ALSVM, która charakteryzuje się niewielką liczbą dodatkowych obliczeń w celu wybrania badanej próbki i zapewnia doskonałe działanie w rzeczywistych zastosowaniach

Aktywne uczenie się na odległość w trybie wsadowym z SVM

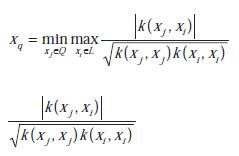

Stosując zapytania wsadowe po prostu wybierano wiele próbek znajdujących się najbliżej granicy decyzyjnej. Jednak dodanie partii takich próbek nie może zapewnić największego zmniejszenia rozmiaru przestrzeni wersji. Chociaż każda próbka może prawie o połowę zmniejszyć przestrzeń wersji, trzy próbki razem mogą nadal zmniejszyć o około 1/2, zamiast 7/8 rozmiaru przestrzeni wersji. Można zaobserwować, że przypisano to małym kątom pomiędzy ich indukowanymi hiperpłaszczyznami. Aby przezwyciężyć ten problem zaproponował nową strategię selekcji poprzez włączenie miary różnorodności, która uwzględnia kąty pomiędzy indukowanymi hiperpłaszczyznami. Niech w bieżącej rundzie oznaczonym zbiorem będzie L, a zbiorem zapytań o pulę Q, następnie w oparciu o kryterium różnorodności należy dodać kolejną próbkę xq

gdzie oznacza wartość cosinus kąta między dwiema hiperpłaszczyznami indukowanymi przez xj i xi, dlatego jest znane jako kryterium zróżnicowania kąta. Można zaobserwować, że zmniejszona objętość przestrzeni wersji na tym rysunku

jest większa niż na rysunku tym

Aktywne uczenie się RETIN

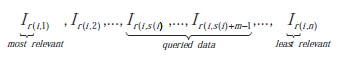

Niech [1... ] ( ) j j n I ∈ będą próbkami w potencjalnym zbiorze zapytań Q, a r(i, k) będzie funkcją, która w iteracji i koduje pozycję k w rankingu istotności ze względu na odległość do bieżącej granicy decyzyjnej, wówczas sekwencję można uzyskać w następujący sposób

W SD-ALSVM s(i) jest takie jak Ir(i,s(i),…,Ir(i,s((i)+m-1 to m próbek najbliższych granicy SVM. Strategia ta domyślnie opiera się na silnym założeniu: dokładne oszacowanie granicy SVM. Jednakże granica decyzyjna jest zwykle niestabilna w początkowych iteracjach.(Gosselin i Cord, 2004) zauważyli, że nawet jeśli granica decyzyjna może się znacznie zmieniać podczas wcześniejszych iteracji, funkcja rankingu r() jest dość stabilne. W związku z tym zaproponowali zrównoważone kryterium wyboru, niezależne od granicy i w którym zaprojektowano metodę adaptacyjną do dostrajania s podczas iteracji ze sprzężeniem zwrotnym. Wyrażano je wzorem

s(i+1) = s(i) +h(rrel(i), rirr(i)

gdzie h(x, y) = k × (x - y) co charakteryzuje dynamikę układu (k jest stałą dodatnią), rrel(i) i rirr(l) oznaczają liczba odpowiednich i nieistotnych próbek w badanym zbiorze w i-tej iteracji. W ten sposób liczba odpowiednich i nieistotnych próbek w badanym zbiorze będzie w przybliżeniu równa.

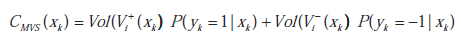

Kryterium średniej przestrzeni wersji

Zaproponowano kryterium wyboru poprzez minimalizację średniej przestrzeni wersji, która jest zdefiniowana jako

gdzie oznacza objętość przestrzeni wersji po dodaniu nieoznakowanej próbki xk do zbioru treningowy i-tej rundy. Średnia przestrzeń wersji obejmuje zarówno objętość przestrzeni wersji, jak i prawdopodobieństwa późniejsze. Uznali zatem, że kryterium jest lepsze niż SD-ALSVM. Jednak obliczenia tą metodą są czasochłonne.

Aktywne uczenie się oparte na wielu widokach

W odróżnieniu od algorytmów opartych tylko na jednym całym zestawie funkcji, metody wielu widoków opierają się na wielu podfunkcjach. Najpierw szkoli się kilka klasyfikatorów na różnych zestawach podcech. Następnie próbki, w przypadku których klasyfikatory wykazują największe rozbieżności, tworzą zbiór rywalizacji, z którego wybierane są badane próbki. Najpierw zastosowano w AL, a potem zaimplementowano go za pomocą ALSVM, aby wygenerować algorytm Co-SVM, który, jak stwierdzono, ma lepszą wydajność niż SD-ALSVM. Wiele klasyfikatorów może znaleźć rzadkie próbki, ponieważ obserwują próbki z różnych perspektyw. Taka właściwość jest bardzo przydatna do wyszukiwania różnych części należących do tej samej kategorii. Jednakże metody oparte na wielu widokach wymagają, aby odpowiedni klasyfikator mógł dobrze sklasyfikować próbki i aby wszystkie zestawy cech były nieskorelowane. Trudno jest zapewnić taki stan w rzeczywistych zastosowaniach.

MIESZANE AKTYWNE NAUCZANIE

Zamiast pojedynczych strategii AL w poprzednich sekcjach, w tej sekcji omówimy dwa mieszane tryby AL: jeden łączy różne kryteria selekcji, a drugi włącza uczenie się częściowo nadzorowane do AL.

Hybrydowe aktywne uczenie się

W przeciwieństwie do opracowania nowego algorytmu AL, który działa dobrze we wszystkich sytuacjach, niektórzy badacze argumentowali, że lepszym sposobem jest łączenie różnych metod, które zwykle się uzupełniają, ponieważ każda metoda ma swoje zalety i wady. Intuicyjna struktura strategii hybrydowej to tryb równoległy. Kluczową kwestią jest tutaj ustawienie wag dla różnych metod AL. Najprostszym sposobem jest ustawienie stałych wag zgodnie z doświadczeniem i było to stosowane w większości istniejących metod. Strategie najbardziej istotne/nieistotne mogą pomóc w ustabilizowaniu granicy decyzyjnej, ale charakteryzują się niskim współczynnikiem uczenia się; podczas gdy standardowe metody oparte na odległości charakteryzują się wysokim współczynnikiem uczenia się, ale mają niestabilne granice na początkowych sprzężeniach zwrotnych. Biorąc to pod uwagę połączono te dwie strategie, aby osiągnąć lepszą wydajność niż stosowanie tylko jednej strategii. Jak stwierdzono wcześniej, strategie oparte na różnorodności i odległości również się uzupełniają, a łączą różnorodność kąta, iloczynu wewnętrznego i entropii strategię odpowiednio ze standardową strategią opartą na odległości. Jednak strategia stałych wag nie może dobrze pasować do wszystkich zbiorów danych i wszystkich iteracji uczenia się. Dlatego wagi należy ustawiać dynamicznie. Wszystkie wagi zostały zainicjowane tą samą wartością i zmodyfikowane w późniejszych iteracjach przy użyciu algorytmu EXP4. W ten sposób empirycznie wykazano, że powstały algorytm AL działa prawie równie dobrze, a czasami przewyższa najlepszy algorytm w zespole.

Aktywne uczenie się częściowo nadzorowane

1. Aktywne uczenie się z transdukcyjnym SVM .Na pierwszych etapach SD-ALSVM kilka oznaczonych danych może prowadzić do dużych odchyleń bieżącego rozwiązania od rozwiązania prawdziwego; natomiast jeśli weźmie się pod uwagę próbki nieoznakowane, rozwiązanie może być bliższe prawdziwemu rozwiązaniu. Pokazano, że im obecne rozwiązanie jest bliższe prawdziwemu, tym większy będzie rozmiar przestrzeni wersji. Włączono transdukcyjny SVM (TSVM), aby opracować dokładniejsze rozwiązania pośrednie. Jednakże w kilku badaniach podważono fakt, że TSVM może nie być tak pomocny w oparciu o nieoznakowane dane w teorii i praktyce. Zastosowano zamiast tego techniki uczenia się częściowo nadzorowanego w oparciu o pola Gaussa i funkcje harmoniczne, a poprawę uznano za znaczącą.

2. Włączanie EM do aktywnego uczenia się .Połączono maksymalizację oczekiwań (EM) ze strategią zadawania pytań przez komisję. Oraz zintegrowany algorytm Multi-view AL z EM aby uzyskać algorytm Co-EMT, który może dobrze działać w sytuacji, gdy widoki są niezgodne i skorelowane.

PRZYSZŁE TRENDY

Jak rozpocząć aktywną naukę

AL można traktować jako problem przeszukiwania funkcji celu w przestrzeni wersji, dlatego ważny jest dobry klasyfikator początkowy. Gdy kategoria obiektywna jest zróżnicowana, ważniejszy staje się klasyfikator początkowy, gdyż zły może skutkować zbieżnością do rozwiązania lokalnego optymalnego, tzn. niektóre części kategorii obiektywnej mogą nie zostać poprawnie objęte klasyfikatorem końcowym. Strategie dwuetapowe , uczenie się długoterminowe oraz strategie przedklastrowe są obiecujące.

Aktywne uczenie się oparte na funkcjach

W AL informacje zwrotne od wyroczni mogą również pomóc w zidentyfikowaniu ważnych cech i wykazały, że takie prace mogą znacznie poprawić wydajność końcowego klasyfikatora. Do identyfikacji ważnych cech wykorzystano analizę głównych składowych. Według naszej wiedzy istnieje niewiele raportów poruszających ten problem.

Skalowanie aktywnego uczenia się

Skalowanie AL do bardzo dużej bazy danych nie zostało jeszcze szczegółowo zbadane. Jest to jednak istotna kwestia dla wielu realnych zastosowań. Zaproponowano pewne podejścia do indeksowania bazy danych oraz przezwyciężania złożoności koncepcji w połączeniu ze skalowalnością zbioru danych.

Algorytmy adaptacyjne dla inteligentnych obliczeń geometrycznych

WSTĘP

Poruszane są tematy z tak ważnych obszarów, jak sztuczna inteligencja, geometria obliczeniowa i technologie biometryczne. Główny nacisk położony jest na proponowany paradygmat obliczeń adaptacyjnych i jego zastosowania do modelowania powierzchni i przetwarzania biometrycznego. Dostępność znacznie tańszych urządzeń do przechowywania danych i urządzeń do przechwytywania obrazów o wysokiej rozdzielczości znacząco przyczyniła się w ciągu ostatnich kilku lat do gromadzenia bardzo dużych zbiorów danych (takich jak mapy GIS, próbki biometryczne, filmy itp.). Z drugiej strony stworzyło także istotne wyzwania, których motywacją jest m.in. większe niż kiedykolwiek wolumeny i złożoność danych, których nie da się już rozwiązać poprzez zakup większej ilości pamięci, szybszych procesorów lub optymalizację istniejących algorytmów. Zmiany te uzasadniały potrzebę radykalnie nowych koncepcji przechowywania, przetwarzania i wizualizacji masowych danych. Wychodząc naprzeciw tej potrzebie, przedstawiono oryginalną metodologię opartą na paradygmacie Adaptive Geometric Computing. Metodologia umożliwia przechowywanie złożonych danych w zwartej formie, zapewniając efektywny dostęp do nich, zachowując wysoki poziom szczegółowości oraz wizualizując dynamiczne zmiany w sposób płynny i ciągły. W pierwszej części rozdziału omówiono algorytmy adaptacyjne w wizualizacji w czasie rzeczywistym, w szczególności w zastosowaniach GIS (Systemy Informacji Geograficznej). Pokrótce omówiono struktury danych, takie jak siatka optymalnie adaptacyjna w czasie rzeczywistym (ROAM) i siatka progresywna (PM). Następnie wprowadzono metodę adaptacyjną Adaptive Spatial Memory (ASM), opracowaną przez R. Apu i M. Gavrilovą. Metoda ta umożliwia szybką i wydajną wizualizację złożonych zbiorów danych reprezentujących tereny, krajobrazy oraz cyfrowe modele wysokości (DEM). Pokrótce omówiono jego zalety. W drugiej części rozdziału przedstawiono zastosowanie paradygmatu obliczeń adaptacyjnych i obliczeń ewolucyjnych do symulacji rakiet. W rezultacie wzory można rozwijać i analizować złożone zachowania. Ostatnia część rozdziału łączy koncepcję obliczeń adaptacyjnych i technik opartych na topologii oraz omawia ich zastosowanie w wymagającym obszarze obliczeń biometrycznych.

TŁO

Przez długi czas badacze zadawali pytania dotyczące realistycznego modelowania obiektów ze świata rzeczywistego (takich jak teren, struktura twarzy czy układ cząstek), przy jednoczesnym zachowaniu wydajności renderowania i przestrzeni. Jako rozwiązanie, w ciągu ostatnich dwóch dekad opracowano siatkę, siatkę, TIN, triangulację Delaunaya i inne metody reprezentacji modelu. Większość z nich to metody statyczne, nieodpowiednie do renderowania dynamicznych scen lub zachowywania wyższego poziomu szczegółów. W 1997 roku opracowano pierwsze metody dynamicznej reprezentacji modelu: Real-time Optimally Adapting Mesh (ROAM) oraz Progressive Mesh (PM) . Zaproponowano różne metody redukcji drobnej siatki do zoptymalizowanej reprezentacji, tak aby zoptymalizowana siatka zawierała mniej prymitywów i zapewniała maksymalne szczegóły. Jednakże podejście to miało dwa główne ograniczenia. Po pierwsze, koszt optymalizacji jest bardzo wysoki (kilka minut na optymalizację jednej średniej wielkości siatki). Po drugie, wygenerowana niejednorodna siatka jest nadal statyczna. W rezultacie daje to słabą jakość, gdy obserwuje się tylko niewielką część siatki. Zatem nawet po dalszym udoskonalaniu metody te nie były w stanie poradzić sobie z dużą ilością złożonych danych ani znacznie zróżnicowanym poziomem szczegółowości. Wkrótce zostały one zastąpione innym modelem obliczeniowym renderowania siatek geometrycznych. W modelu zastosowano kryteria ciągłego udoskonalania oparte na metryce błędu, aby optymalnie dostosować się do dokładniejszej reprezentacji. Dlatego też, biorąc pod uwagę reprezentację siatki i niewielką zmianę punktu obserwacji, zoptymalizowaną siatkę dla następnego punktu obserwacji można obliczyć poprzez udoskonalenie istniejącej siatki

Adaptacyjne obliczenia geometryczne

Przedstawiono adaptacyjną technikę wielorozdzielczości do wizualizacji terenu w czasie rzeczywistym, wykorzystującą sprytny sposób dynamicznej optymalizacji siatki w celu uzyskania płynnej i ciągłej wizualizacji z bardzo wysoką wydajnością (liczba klatek na sekundę) . Nasza metoda charakteryzuje się wydajną reprezentacją ogromnego terenu, wykorzystuje efektywne przejście między poziomami szczegółowości i osiąga stałą liczbę klatek na sekundę, zapewniając ciągłość wizualną. U podstaw tej metody leży przetwarzanie adaptacyjne: sformalizowana hierarchiczna reprezentacja, która wykorzystuje zasadę późniejszego udoskonalania. Dzięki temu mamy pełną kontrolę nad złożonością przestrzeni cech. Metryka błędu jest przypisywana w procesie wyższego poziomu, w którym obiekty (lub cechy) są początkowo klasyfikowane do różnych etykiet. Zatem ta metoda adaptacyjna jest bardzo przydatna do reprezentacji przestrzeni cech. W 2006 roku Gavrilova i Apu wykazali, że takie metody mogą działać jako potężne narzędzie nie tylko do renderowania terenu, ale także do planowania ruchu i symulacji adaptacyjnych . Wprowadzili model adaptacyjnej pamięci przestrzennej (ASM), który wykorzystuje podejście adaptacyjne do algorytmu online działającego w czasie rzeczywistym na potrzeby wspólnego planowania ruchu przez wielu agentów. Wykazali, że potężne pojęcie obliczeń adaptacyjnych można zastosować do percepcji i zrozumienia przestrzeni. Stwierdzono, że rozszerzenie tej metody na potrzeby planowania ruchu w 3D w ramach wspólnych badań z grupą prof. I. Kolingerowej jest znacznie skuteczniejsze niż metody konwencjonalne. Najpierw przejdziemy do omówienia obliczeń ewolucyjnych. Demonstrujemy siłę obliczeń adaptacyjnych, opracowując i stosując adaptacyjny model obliczeniowy do symulacji rakiety. Opisane powyżej opracowane algorytmy adaptacyjne mają tę właściwość, że jednostki pamięci przestrzennej mogą tworzyć, udoskonalać i zwijać się, symulując uczenie się, adaptację i reagowanie na bodźce. Rezultatem jest złożony, wieloagentowy algorytm uczenia się, który wyraźnie demonstruje zachowania organiczne, takie jak poczucie terytorium, szlaki, ślady itp. obserwowane w stadach dzikich zwierząt i owadów. Daje to motywację do zbadania mechanizmu mającego zastosowanie do modelowania zachowań roju. Inteligencja roju (SI) jest właściwością systemu, w którym zbiorowe zachowania prostych agentów wchodzących w interakcję lokalnie ze swoim otoczeniem powodują wyłonienie się spójnych, funkcjonalnych, globalnych wzorców. Podstawą jest inteligencja roju do badania zbiorowego (rozproszonego) zachowania grupy agentów bez scentralizowanej kontroli lub zapewnienia modelu globalnego. Agenci w takim systemie mają ograniczoną percepcję (lub inteligencję) i nie są w stanie samodzielnie wykonywać złożonych zadań. Według Bonebeau regulując zachowanie agentów w roju, można wykazać wyłaniające się zachowanie i inteligencję jako zjawisko zbiorowe. Chociaż zjawisko rojenia jest w dużej mierze obserwowane w organizmach biologicznych, takich jak kolonia mrówek czy stado ptaków, ostatnio wykorzystuje się je do symulacji złożonych układów dynamicznych skupionych na osiągnięciu dobrze określonego celu. Przyjrzyjmy się teraz zastosowaniu adaptacyjnego paradygmatu obliczeniowego i koncepcji inteligencji roju do symulacji zachowania rakiety . Przede wszystkim zauważmy, że złożone zachowanie strategiczne można zaobserwować za pomocą zadaniowego sztucznego procesu ewolucyjnego, w którym zachowania poszczególnych rakiet są opisywane z zaskakującą prostotą. Po drugie, globalna skuteczność i zachowanie na rój rakietowy stosunkowo nie ma wpływu zakłócenie lub zniszczenie poszczególnych jednostek. Ze strategicznego punktu widzenia to zachowanie adaptacyjne jest bardzo pożądaną właściwością w zastosowaniach wojskowych, co motywuje nasze zainteresowanie zastosowaniem go do symulacji rakiet. Należy zauważyć, że problem ten został wybrany, ponieważ stanowi złożone wyzwanie, dla którego bardzo trudno jest uzyskać optymalne rozwiązanie przy użyciu tradycyjnych metod. Dynamiczna i konkurencyjna relacja między rakietami i wieżami sprawia, że modelowanie przy użyciu podejścia deterministycznego jest niezwykle trudne. Należy także zaznaczyć, że problem posiada łatwą metrykę ewaluacyjną, pozwalającą na precyzyjne określenie wartości przystosowania. Podsumujmy teraz ideę optymalizacji ewolucyjnej poprzez zastosowanie algorytmu genetycznego do ewolucji genotypu rakiety. Jesteśmy szczególnie zainteresowani obserwacją ewolucji złożonych formacji 3D i strategii taktycznych, których rój uczy się maksymalizować ich skuteczność podczas symulacji ataku. Symulacja opiera się na ataku, uniku i obronie. Podczas gdy rakieta ustala strategię uderzenia w cel, okręt bojowy przygotowuje się do zestrzelenia jak największej liczby rakiet (rysunek 2 ilustruje podstawowe manewry rakiety). Każda próba zniszczenia celu nazywana jest symulacją ataku. Jego skuteczność jest równa liczbie rakiet trafiających w cel. Dlatego wynik symulacji jest łatwo wymierny. Z drugiej strony interakcja między rakietami a pancernikiem jest złożona i nietrywialna. W rezultacie mogą pojawić się strategie wojenne, w których lokalna kara (tj. poświęcenie rakiety) może zoptymalizować globalną skuteczność (tj. strategia oszustwa). Najprostszą formą informacji znaną każdemu pociskowi jest jego położenie i orientacja oraz lokalizacja celu. Informacje te są uzupełniane o informacje o sąsiedztwie i środowisku rakiety, co wpływa na sposób nawigacji rakiety. Do rzeczywistej symulacji zachowania rakiety używamy strategii opartej na zmodyfikowanej wersji techniki flokowania Boidów. Właśnie nakreśliliśmy niezbędny zestaw działań, aby osiągnąć cel lub wejść w interakcję z otoczeniem. Jest to podstawowy element nawigacji rakietowej. Ciąg genów to kolejna ważna część odzwierciedlająca złożoność, z jaką można wybrać takie kierunki działania. Zawiera unikalną kombinację manewrów (takich jak atak, unik itp.), które ewoluują, tworząc złożoną połączoną inteligencję. Opisujemy przydatność genu rakiety pod względem zbiorowej wydajności. Po zbadaniu różnych możliwości opracowaliśmy i wykorzystaliśmy dwuwymiarową funkcję adaptacyjnego przystosowania do ewolucji naprężeń rakietowych w jednym systemie ewolucyjnym.. Po szeroko zakrojonych eksperymentach odkryliśmy wiele interesujących cech, takich jak geometryczna formacja ataku i organiczne zachowania obserwowane wśród rojów, a także bardzo oczekiwane strategie, takie jak równoczesny atak, oszustwo, odwrót i inne strategie. Zbadaliśmy także zdolność adaptacji poprzez losowanie współrzędnych symulacji, odległości, formacji początkowej, szybkości ataku i innych parametrów rakiet oraz zmierzyliśmy średnią i wariancję funkcji przystosowania. Wyniki wykazały, że wiele wyewoluowanych genotypów w dużym stopniu przystosowuje się do środowiska. Właśnie dokonaliśmy przeglądu zastosowania adaptacyjnego paradygmatu obliczeniowego do inteligencji roju i krótko opisaliśmy skuteczną metodę taktycznej symulacji roju. Wyniki wyraźnie pokazują, że rój jest w stanie opracować złożoną strategię w drodze ewolucyjnego procesu mutacji genotypowej. Jak stwierdzono we wstępie, obliczenia adaptacyjne opierają się na paradygmacie o zmiennym poziomie złożoności szczegółowości, w którym zjawisko fizyczne można symulować poprzez ciągły proces lokalnej adaptacji złożoności przestrzennej. Jak zaprezentowała M. Gavrilova w wykładzie plenarnym na konferencji 3IA Eurographics Conference we Francji w 2006 r., paradygmat adaptacyjny jest potężnym modelem obliczeniowym, który można również zastosować w rozległym obszarze badań biometrycznych. Dlatego w tej części dokonano przeglądu metod i technik opartych na adaptacyjnych metodach geometrycznych w zastosowaniu do problemów biometrycznych. Podkreśla korzyści, jakie inteligentne podejście do obliczeń geometrycznych wnosi do obszaru złożonego przetwarzania danych biometrycznych . W technologii informacyjnej biometria odnosi się do badania cech fizycznych i behawioralnych w celu identyfikacji osoby. W ostatnich latach obszar biometrii odnotował ogromny rozwój, częściowo w wyniku pilnej potrzeby zwiększenia bezpieczeństwa, a częściowo w odpowiedzi na nowy postęp technologiczny, który dosłownie zmienia nasz sposób życia. Dostępność znacznie tańszych pamięci masowych i urządzeń do biometrycznego przechwytywania obrazu o wysokiej rozdzielczości przyczyniły się do gromadzenia bardzo dużych zbiorów danych biometrycznych. We wcześniejszych sekcjach badaliśmy tło adaptacyjnego generowania siatki. Przyjrzyjmy się teraz badaniom podstawowym w zakresie struktur danych opartych na topologii i ich zastosowaniu w badaniach biometrycznych. Informacje te są bardzo istotne dla celów modelowania i wizualizacji złożonych danych biometrycznych. W tym samym czasie, gdy rozwijała się metodologia adaptacyjna w GIS, znacznie wzrosło zainteresowanie strukturami danych opartymi na topologii, takimi jak diagramy Woronoja i triangulacje Delaunaya. Zaczęły pojawiać się wstępne wyniki dotyczące wykorzystania tych struktur danych opartych na topologii w biometrii. Niedawno uzyskano kilka interesujących wyników w BTLab na Uniwersytecie Calgary poprzez opracowanie algorytmów ekstrakcji cech w oparciu o topologię do dopasowywania odcisków palców , modelowania wyrazu twarzy 3D oraz syntezę tęczówki . Kompleksowy przegląd podejść opartych na topologii w modelowaniu i syntezie biometrycznej można znaleźć w najnowszym rozdziale książki na ten temat .Proponujemy radzenie sobie z wyzwaniami wynikającymi z dużych ilości złożonych danych biometrycznych poprzez innowacyjne wykorzystanie paradygmatu adaptacyjnego. Sugerujemy połączenie metodologii opartej na topologii i hierarchii do przechowywania i wyszukiwania danych biometrycznych, a także optymalizacji takiej reprezentacji w oparciu o dostęp do danych i wykorzystanie. Mianowicie odzyskiwanie danych, czyli tworzenie wizualizacji w czasie rzeczywistym, może opierać się na dynamicznym wzorcu wykorzystania danych (jak często, jaki rodzaj danych, ile szczegółów itp.), rejestrowanym i analizowanym w procesie systemu biometrycznego wykorzystywane do celów rozpoznania i identyfikacji. Oprócz wykorzystania tych informacji do zoptymalizowanej reprezentacji i wyszukiwania danych, proponujemy również włączenie inteligentnych technik uczenia się w celu przewidywania najbardziej prawdopodobnych wzorców wykorzystania systemu oraz odpowiedniego reprezentowania i organizowania danych. Z praktycznego punktu widzenia, aby osiągnąć nasz cel, proponujemy nowatorski sposób reprezentowania złożonych danych biometrycznych poprzez organizację danych w hierarchiczną strukturę przypominającą drzewo. Taka organizacja jest w zasadzie podobna do pododdziału pamięci adaptacyjnej (AMS), zdolnej do reprezentowania i wyszukiwania różnej ilości informacji i poziomu szczegółowości, które muszą być reprezentowane. Przestrzenne drzewo czworokątne służy do przechowywania informacji o systemie, a także instrukcji dotyczących przetwarzania tych informacji. Rozszerzanie odbywa się poprzez technikę podziału przestrzennego, która udoskonala dane i zwiększa poziom szczegółowości, a zwijanie odbywa się poprzez operację scalania, która upraszcza reprezentację danych i czyni ją bardziej zwartą. Strategia zachłanna służy do optymalnego dostosowania się do najlepszej reprezentacji w oparciu o wymagania użytkownika, ilość dostępnych danych i zasobów, wymaganą rozdzielczość i tak dalej. Ta potężna technika pozwala nam osiągnąć cel, jakim jest zwarta reprezentacja danych biometrycznych, która pozwala na przykład efektywnie przechowywać drobne szczegóły modelowanej twarzy (np. blizny, zmarszczki) czy szczegółowe wzorce tęczówki.

PRZYSZŁE TRENDY

Oprócz reprezentacji danych technika adaptacyjna może być bardzo użyteczna w ekstrakcji cech biometrycznych w celu szybkiego i niezawodnego wyszukiwania i dopasowywania danych biometrycznych oraz we wdrażaniu dynamicznych zmian w modelu. Metodologia ma duży potencjał, aby stać się jednym z kluczowych podejść w modelowaniu i syntezie danych biometrycznych.

WNIOSEK

Dokonano przeglądu adaptacyjnego paradygmatu obliczeniowego w zastosowaniu do modelowania powierzchni, obliczeń ewolucyjnych i badań biometrycznych. Niektóre z kluczowych przyszłych wydarzeń w nadchodzących latach niewątpliwie uwydatnią ten obszar, inspirując nowe generacje inteligentnych systemów biometrycznych z zachowaniem adaptacyjnym.

WSTĘP

Odkąd nadeszła era komputerów, jednym z najważniejszych obszarów technologii informatycznych było "wspomaganie decyzji". Dziś ten obszar jest ważniejszy niż kiedykolwiek. Pracując w dynamicznym i ciągle zmieniającym się środowisku, współcześni menedżerowie są odpowiedzialni za szereg dalekosiężnych decyzji: czy firma powinna zwiększyć czy zmniejszyć liczbę pracowników? Wejść na nowe rynki? Opracowywać nowe produkty? Inwestować w badania i rozwój? I tak dalej. Jednak pomimo nieodłącznej złożoności tych kwestii i stale rosnącego ładunku informacji, z którymi muszą sobie radzić menedżerowie biznesowi, wszystkie te decyzje sprowadzają się do dwóch podstawowych pytań: Co prawdopodobnie wydarzy się w przyszłości? Jaka jest obecnie najlepsza decyzja? Niezależnie od tego, czy zdajemy sobie z tego sprawę, czy nie, te dwa pytania przenikają nasze codzienne życie - zarówno na poziomie osobistym, jak i zawodowym. Jadąc na przykład do pracy, musimy przewidzieć natężenie ruchu, zanim będziemy mogli wybrać najszybszą trasę dojazdu. W pracy musimy przewidzieć popyt na nasz produkt, zanim będziemy mogli zdecydować, ile go wyprodukować. Zanim zainwestujemy na rynku zagranicznym, musimy przewidzieć przyszłe kursy walut i zmienne ekonomiczne. Wydaje się, że niezależnie od podejmowanej decyzji i jej złożoności, najpierw trzeba przewidzieć, co prawdopodobnie wydarzy się w przyszłości, a następnie na tej podstawie podjąć najlepszą decyzję. Ten fundamentalny proces leży u podstaw podstawowych założeń Adaptive Business Intelligence.

TŁO

Mówiąc najprościej, Adaptive Business Intelligence to dyscyplina łącząca przewidywanie, optymalizację i zdolność adaptacji w system będący w stanie odpowiedzieć na te dwa podstawowe pytania: Co prawdopodobnie wydarzy się w przyszłości? i Jaka jest obecnie najlepsza decyzja? . Aby zbudować taki system, musimy najpierw zrozumieć metody i techniki umożliwiające przewidywanie, optymalizację i adaptację (Dhar i Stein, 1997). Na pierwszy rzut oka tematyka ta nie jest niczym nowym, gdyż na temat analityki biznesowej (Vitt i in., 2002; Loshin, 2003), eksploracji danych i metod przewidywania napisano już setki książek i artykułów (Weiss i Indurkhya, 1998; Witten). i Frank, 2005), metody prognozowania (Makridakis i in., 1988), techniki optymalizacji (Deb 2001; Coello i in. 2002; Michalewicz i Fogel, 2004) i tak dalej. Jednak w żadnym z nich nie wyjaśniono, jak połączyć te różne technologie w system oprogramowania, który jest w stanie przewidywać, optymalizować i dostosowywać. Adaptive Business Intelligence rozwiązuje właśnie ten problem. Jest oczywiste, że przyszłość branży analityki biznesowej leży w systemach mogących podejmować decyzje, a nie w narzędziach generujących szczegółowe raporty (Loshin 2003). Większość menedżerów biznesowych zdaje sobie teraz sprawę, że istnieje ogromna różnica między posiadaniem dobrej wiedzy i szczegółowych raportów a podejmowaniem mądrych decyzji. Michael Kahn, reporter technologiczny agencji Reuters w San Francisco, w artykule z 16 stycznia 2006 r. zatytułowanym "Oprogramowanie do analizy biznesowej patrzy w przyszłość" przedstawia słuszną uwagę: "Ale analitycy twierdzą, że aplikacje, które faktycznie odpowiadają na pytania, a nie tylko przedstawiają góry danych, są kluczowy czynnik napędzający rynek, który w 2006 r. ma wzrosnąć o 10 procent, czyli około dwukrotnie szybciej niż ogólnie w przypadku branży oprogramowania biznesowego.

"Coraz częściej powstają aplikacje, które skutkują jakimś działaniem" - powiedział Brendan Barnacle, analityk w Pacific Crest Equities. "Obecnie jest to stosunkowo niewielka część, ale wyraźnie widać, gdzie jest przyszłość. To kolejny etap inteligencji biznesowej."

GŁÓWNY TEMAT

"Odpowiedź na mój problem jest ukryta w moich danych

ale nie mogę jej odkopać!" To popularne stwierdzenie krąży od lat, kiedy menedżerowie biznesowi gromadzili i przechowywali ogromne ilości danych w przekonaniu, że zawierają one cenne informacje. Ale menedżerowie biznesowi w końcu odkryLI, że surowe dane rzadko przynoszą jakąkolwiek korzyść, a ich rzeczywista wartość zależy od zdolności organizacji do ich analizy. W związku z tym pojawiło się zapotrzebowanie na systemy oprogramowania zdolne do wyszukiwania, podsumowywania i interpretowania danych dla użytkowników końcowych. Potrzeba ta doprowadziła do powstania setek firm zajmujących się analityką biznesową, które specjalizowały się w dostarczaniu systemów oprogramowania i usług wydobywania wiedzy z surowych danych. Te systemy oprogramowania analizowałyby dane operacyjne firmy i dostarczały wiedzy w postaci tabel, wykresów, wykresów i innych statystyk. Na przykład raport analityki biznesowej może stwierdzać, że 57% klientów to osoby w wieku od 40 do 50 lat lub że produkt X sprzedaje się na Florydzie znacznie lepiej niż w Gruzji.1 W związku z tym ogólnym celem większości systemów analityki biznesowej było: (1) uzyskać dostęp do danych z różnych źródeł; (2) przekształcić te dane w informację, a następnie w wiedzę; oraz (3) zapewnia łatwy w użyciu interfejs graficzny do wyświetlania tej wiedzy. Innymi słowy, system business intelligence miał za zadanie zbierać i trawić dane oraz prezentować wiedzę w przyjazny sposób (zwiększając w ten sposób zdolność użytkownika końcowego do podejmowania trafnych decyzji). Chociaż różne teksty ilustrują związek między danymi a wiedzą na różne sposoby (np. Davenport i Prusak, 2006; Prusak, 1997; Shortliffe i Cimino, 2006), powszechnie akceptowane rozróżnienie między danymi, informacją i wiedzą brzmi: Dane są gromadzone na co dzień w postaci bitów, liczb, symboli i "obiektów". Informacja to "uporządkowane dane", które są wstępnie przetwarzane, oczyszczane, układane w struktury i pozbawione nadmiarowości. Wiedza to "zintegrowana informacja", która obejmuje fakty i relacje, które zostały dostrzeżone, odkryte lub wyuczone. Ponieważ wiedza jest istotnym elementem każdego procesu decyzyjnego (jak mówi stare powiedzenie: "Wiedza to potęga!"), wiele firm postrzega wiedzę jako ostateczny cel. Wygląda jednak na to, że wiedza już nie wystarczy. Firma może "wiedzieć" dużo o swoich klientach - może mieć setki wykresów i wykresów porządkujących klientów według wieku, preferencji, lokalizacji geograficznej i historii sprzedaży - ale kierownictwo może nadal nie być pewne, jaką decyzję podjąć! I tu leży różnica pomiędzy "wspieraniem decyzji" a "podejmowaniem decyzji": cała wiedza świata nie gwarantuje podjęcia właściwej i najlepszej decyzji. Co więcej, ostatnie badania z zakresu psychologii wskazują, że szeroko rozpowszechnione przekonania mogą w rzeczywistości utrudniać proces podejmowania decyzji. Na przykład powszechne przekonania, takie jak "im więcej mamy wiedzy, tym lepsze będą nasze decyzje" lub "potrafimy odróżnić wiedzę użyteczną od nieistotnej", nie są poparte dowodami empirycznymi. Posiadanie większej wiedzy jedynie zwiększa naszą pewność siebie, ale nie poprawia trafności naszych decyzji. Podobnie ludzie zaopatrywani w "dobrą" i "złą" wiedzę często mają problem z rozróżnieniem między nimi, udowadniając, że nieistotna wiedza zmniejsza skuteczność podejmowania decyzji. Obecnie większość menedżerów przedsiębiorstw zdaje sobie sprawę, że istnieje luka między posiadaniem odpowiedniej wiedzy a podejmowaniem właściwych decyzji. Ponieważ luka ta wpływa na zdolność kierownictwa do odpowiedzi na podstawowe pytania biznesowe (takie jak "Co należy zrobić, aby zwiększyć zyski? Zmniejszyć koszty? Lub zwiększyć udział w rynku?"), przyszłość analityki biznesowej leży raczej w systemach, które mogą dostarczać odpowiedzi i rekomendacji. niż Kopce wiedzy w formie raportów. Przyszłość inteligencji biznesowej leży w systemach, które mogą podejmować decyzje! W rezultacie na rynku pojawia się nowy trend o nazwie Adaptive Business Intelligence. Oprócz pełnienia roli tradycyjnego business intelligence (przekształcania danych w wiedzę), Adaptive Business Intelligence obejmuje także proces decyzyjny, który opiera się na przewidywaniu i optymalizacji.Podczas gdy inteligencję biznesową często definiuje się jako "szeroką kategorię programów użytkowych i technologii służących do gromadzenia, przechowywania, analizowania i zapewniania dostępu do danych", termin Adaptive Business Intelligence można zdefiniować jako "dyscyplinę polegającą na wykorzystywaniu technik przewidywania i optymalizacji do budowania samouczące się systemy "decyzyjne"" (jak pokazuje powyższy diagram). Adaptacyjne systemy Business Intelligence obejmują elementy eksploracji danych, modelowania predykcyjnego, prognozowania, optymalizacji i zdolności adaptacyjnych i są wykorzystywane przez menedżerów biznesowych do podejmowania lepszych decyzji. To stosunkowo nowe podejście do analityki biznesowej może zalecić najlepszy sposób działania (na podstawie danych z przeszłości), ale robi to w bardzo szczególny sposób: system Adaptive Business Intelligence zawiera moduły przewidywania i optymalizacji, które rekomendują decyzje niemal optymalne, oraz "moduł adaptacji" umożliwiający ulepszanie przyszłych zaleceń. Takie systemy mogą pomóc menedżerom biznesowym w podejmowaniu decyzji zwiększających wydajność, produktywność i konkurencyjność. Co więcej, nie można przecenić znaczenia zdolności adaptacyjnych. W końcu jaki jest sens używania oprogramowania, które za każdym razem generuje niepełne harmonogramy, niedokładne prognozy popytu i gorsze plany logistyczne? Czy nie byłoby wspaniale zastosować system oprogramowania, który mógłby dostosować się do zmian na rynku? System oprogramowania, który z czasem mógłby być udoskonalany?

PRZYSZŁE TRENDY

Koncepcja adaptowalności z pewnością zyskuje na popularności, i to nie tylko w sektorze oprogramowania. Możliwości adaptacji wprowadzono już we wszystkim, począwszy od automatycznych skrzyń biegów w samochodach (które dostosowują sposób zmiany biegów do stylu jazdy kierowcy), po buty do biegania (dostosowujące poziom amortyzacji do wzrostu i kroku biegacza), aż po wyszukiwarki internetowe (które dostosowują się do ich wyniki wyszukiwania do preferencji użytkownika i wcześniejszej historii wyszukiwania). Produkty te cieszą się dużym zainteresowaniem konsumentów indywidualnych, gdyż pomimo masowej produkcji, po pewnym czasie potrafią dostosować się do preferencji każdego niepowtarzalnego właściciela. Rosnącą popularność zdolności adaptacyjnych podkreśla także niedawna publikacja Departamentu Obrony USA. Zawiera listę 19 ważnych tematów badawczych na następną dekadę, a wiele z nich zawiera termin "adaptacyjny": adaptacyjne skoordynowane sterowanie na dynamicznym polu bitwy wieloagentowym 3D, sterowanie systemami adaptacyjnymi i współpracującymi, interoperacyjność systemów adaptacyjnych, materiały adaptacyjne do pochłaniania energii

Struktury i złożone sieci adaptacyjne do kontroli kooperacyjnej.

Z pewnością już dawno za ważny składnik inteligencji uznano zdolność adaptacji: Alfred Binet (ur. 1857), francuski psycholog i wynalazca pierwszego testu na inteligencję użyteczną, zdefiniował inteligencję jako "...osąd, inaczej zwany zdrowym rozsądkiem, zmysłem praktycznym inicjatywa, zdolność dostosowywania się do okoliczności. Zdolność do adaptacji jest istotnym elementem każdego inteligentnego systemu, ponieważ trudno argumentować, że system jest "inteligentny", jeśli nie ma zdolności do adaptacji. Dla ludzi znaczenie zdolności adaptacyjnych jest oczywiste: nasza zdolność do adaptacji była kluczowym elementem procesu ewolucyjnego. W psychologii zachowanie lub cecha ma charakter adaptacyjny, gdy pomaga jednostce dostosować się i dobrze funkcjonować w zmieniającym się środowisku społecznym. W przypadku sztucznej inteligencji rozważmy szachy program zdolny pokonać światowego mistrza szachowego: Czy powinniśmy nazwać ten program inteligentnym? Prawdopodobnie nie. Wydajność programu możemy przypisać jego zdolności do oceny aktualnej sytuacji na tablicy w porównaniu z wieloma możliwymi "przyszłymi tablicami" przed wybraniem najlepszego ruchu. Ponieważ jednak program nie może nauczyć się nowych zasad ani dostosować do nich, utraci swoją skuteczność, jeśli zasady gry ulegną zmianie lub modyfikacji. W konsekwencji, ponieważ program nie jest w stanie nauczyć się nowych zasad ani przystosować się do nich, nie jest inteligentny. To samo dotyczy każdego systemu ekspertowego. Nikt nie kwestionuje przydatności systemów ekspertowych w niektórych środowiskach (które są zwykle dobrze zdefiniowane i statyczne), ale systemów ekspertowych, które nie są zdolne do uczenia się i adaptacji, nie należy nazywać "inteligentnymi". Zaprogramowano pewną wiedzę ekspercką, to wszystko. Jakie są zatem przyszłe trendy w zakresie Adaptive Business Intelligence? Według słów Jima Goodnighta, dyrektora generalnego SAS Institute (Collins i in. 007): "Do niedawna wywiad biznesowy ograniczał się do podstawowych zapytań i raportowania i tak naprawdę nigdy nie zapewniał tak dużej inteligencji

" Jednak to ma się wkrótce zmienić. Keith Collins, dyrektor ds. technologii w SAS Institute uważa, że: "Pojawia się nowa definicja platformy dla analityki biznesowej, w której BI nie jest już definiowana jako proste zapytanie i raportowanie. [

] W ciągu najbliższych pięciu lat zobaczymy także zmianę w zarządzaniu wynikami w stronę tego, co nazywamy predykcyjnym zarządzaniem wydajnością, w którym analityka odgrywa ogromną rolę w przechodzeniu od prostych wskaźników do bardziej skutecznych mierników". Ponadto Jim Davis, wiceprezes ds. marketingu w SAS Institute (Collins i in. 2007) stwierdził:

"W ciągu najbliższych trzech do pięciu lat osiągniemy punkt zwrotny, w którym więcej organizacji będzie korzystać z BI, aby skupić się na optymalizacji procesów i wywieraniu wpływu na wyniki finansowe

"

Wreszcie ważne byłoby uwzględnienie zdolności adaptacyjnych w komponentach przewidywania i optymalizacji przyszłych systemów Adaptive Business Intelligence. Odnotowano kilka niedawnych udanych wdrożeń systemów Adaptive Business Intelligence (np. Michalewicz i in. 2005), które zapewniają codzienne wsparcie decyzyjne dużym korporacjom i skutkują wielomilionowym zwrotem z inwestycji. Istnieją również firmy (np. www.solveitsoftware.com), które specjalizują się w rozwoju narzędzi Adaptive Business Intelligence. Konieczne są jednak dalsze wysiłki badawcze. Na przykład większość badań dotyczy uczenia maszynowego skupiła się na wykorzystaniu danych historycznych do budowy modeli predykcyjnych. Po zbudowaniu i ocenie modelu cel zostaje osiągnięty. Ponieważ jednak nowe dane pojawiają się w regularnych odstępach czasu, budowanie i ocena modelu to dopiero pierwszy krok w adaptacyjnej analizie biznesowej. Ponieważ modele te muszą być regularnie aktualizowane (coś, za co odpowiedzialny jest moduł adaptacji), spodziewamy się większego nacisku na ten proces aktualizacji w badaniach nad uczeniem maszynowym. Również częstotliwość aktualizacji modułu przewidywania, która może wahać się od sekund (np. w systemach handlu walutami w czasie rzeczywistym) do tygodni i miesięcy (np. w systemach wykrywania oszustw) może wymagać różnych technik i metodologii. Ogólnie rzecz biorąc, systemy Adaptive Business Intelligence obejmują między innymi wyniki badań z zakresu teorii sterowania, statystyki, badań operacyjnych, uczenia maszynowego i nowoczesnych metod heurystycznych. Oczekujemy również, że w nowoczesnych technikach optymalizacji nadal będą dokonywane duże postępy. W nadchodzących latach coraz więcej publikacji naukowych będzie publikowanych na temat problemów optymalizacyjnych z ograniczeniami i wieloma celami, oraz na problemach optymalizacyjnych stawianych w środowiskach dynamicznych. Jest to istotne, ponieważ większość rzeczywistych problemów biznesowych jest ograniczona, wielocelowa i osadzona w zmieniającym się czasie środowisku.

WNIOSEK

Nic dziwnego, że podstawowe komponenty Adaptive Business Intelligence pojawiają się już w innych obszarach biznesu. Na przykład metodologia Six Sigma jest doskonałym przykładem dobrze zorganizowanej, opartej na danych metodologii eliminowania defektów, odpadów i problemów z kontrolą jakości w wielu branżach. Należy zauważyć, że powyższa sekwencja jest bardzo zbliżona "w duchu" do części poprzedniego diagramu, ponieważ opisuje (bardziej szczegółowo) pętlę kontroli zdolności adaptacyjnych. Jest oczywiste, że musimy "mierzyć", "analizować" i "udoskonalać", ponieważ działamy w dynamicznym środowisku, więc proces doskonalenia jest ciągły. Instytut SAS proponuje inną metodologię, która jest bardziej zorientowana na działania związane z eksploracją danych. Ich metodologia zaleca sekwencję kroków pokazaną na rysunku 4. Ponownie zauważmy, że powyższa sekwencja jest bardzo zbliżona do innej części naszego diagramu, ponieważ opisuje (bardziej szczegółowo) transformację od danych do wiedzy. Nic więc dziwnego, że przedsiębiorstwa kładą duży nacisk na te obszary, gdyż lepsze decyzje zazwyczaj przekładają się na lepsze wyniki finansowe. Lepsze wyniki finansowe to właśnie to, o co chodzi w Adaptive Business Intelligence. Systemy oparte na Adaptive Business Intelligence mają na celu rozwiązywanie rzeczywistych problemów biznesowych, które mają złożone ograniczenia, są osadzone w zmieniających się w czasie środowiskach, mają kilka (prawdopodobnie sprzecznych) celów i gdzie liczba możliwych rozwiązań jest zbyt duża, aby je wyliczyć. Rozwiązanie tych problemów wymaga systemu zawierającego moduły przewidywania, optymalizacji i dostosowywania.

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

WSTĘP

Sztuczne sieci neuronowe (ANN) (McCulloch i Pitts, 1943) opracowano jako modele ich biologicznych odpowiedników, których celem było naśladowanie rzeczywistych układów neuronowych oraz naśladowanie strukturalnej organizacji i funkcji ludzkiego mózgu. Ich zastosowania opierały się na możliwości samodzielnego projektowania rozwiązania problemu poprzez uczenie się rozwiązania z danych. Przeprowadzono badanie porównawcze implementacji neuronowych wykorzystujących analizę głównych składowych (PCA) i analizę składowych niezależnych (ICA). Do krytycznej oceny i oceny wiarygodności prognoz danych wykorzystano sztucznie wygenerowane dane, dodatkowo zniekształcone białym szumem w celu wymuszenia losowości. Analiza zarówno w dziedzinie czasu, jak i częstotliwości wykazała wyższość oszacowanych niezależnych składowych (IC) w stosunku do głównych składowych (PC) w wiernym odtworzeniu autentycznych (utajonych) sygnałów źródłowych. Obliczenia neuronowe należą do przetwarzania informacji polegającego na adaptacyjnym, równoległym i rozproszonym (lokalnym) przetwarzaniu sygnałów. W analizie danych częstym zadaniem jest znalezienie odpowiedniej podprzestrzeni danych wielowymiarowych do późniejszego przetwarzania i interpretacji. Transformacje liniowe są często stosowane przy wyborze modelu danych ze względu na ich prostotę obliczeniową i koncepcyjną. Niektóre popularne transformaty liniowe to PCA, analiza czynnikowa (FA), dążenie do projekcji (PP), a ostatnio ICA . Ten ostatni pojawił się jako rozszerzenie nieliniowego PCA i rozwinął się w kontekście ślepej separacji źródła (BSS) w przetwarzaniu sygnałów i tablic. ICA ma także związek z najnowszymi teoriami mózgu wzrokowego, które zakładają, że kolejne etapy przetwarzania prowadzą do stopniowego zmniejszania redundancji reprezentacji. Artykuł ten stanowi przegląd architektur neuromorficznych PCA i ICA oraz powiązanych z nimi implementacji algorytmicznych, coraz częściej wykorzystywanych jako techniki eksploracyjne. Dyskusja toczy się na sztucznie generowanych sygnałach źródłowych sub- i supergaussowskich.

TŁO

W obliczeniach neuronowych metody przekształcania sprowadzają się do uczenia się bez nadzoru, ponieważ reprezentacji uczymy się wyłącznie na podstawie danych bez żadnej zewnętrznej kontroli. Niezależnie od charakteru uczenia się, adaptację neuronową można formalnie potraktować jako problem optymalizacji: funkcja celu opisuje zadanie, jakie ma wykonać sieć, a numeryczna procedura optymalizacji pozwala na dostosowanie parametrów sieci (np. wag połączeń, obciążenia, parametrów wewnętrznych). Proces ten sprowadza się do wyszukiwania lub programowania nieliniowego w dość dużej przestrzeni parametrów. Jednakże wszelka wcześniejsza wiedza dostępna na temat rozwiązania może zostać skutecznie wykorzystana do zawężenia przestrzeni poszukiwań. W uczeniu się nadzorowanym dodatkowa wiedza jest włączana do architektury sieci lub reguł uczenia się (Gold, 1996). Mniej obszerne badania skupiały się na uczeniu się bez nadzoru. Pod tym względem zwykle stosowane metody matematyczne wywodzą się z klasycznej wielowymiarowej optymalizacji nieliniowej z ograniczeniami i opierają się na metodzie mnożników Lagrange′a, technikach kar lub barier oraz klasycznych technikach algebry numerycznej, takich jak deflacja/renormalizacja, Procedura ortogonalizacji Grama-Schmidta, czyli rzutowanie na grupę ortogonalną

Modele PCA i ICA

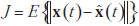

Matematycznie liniowe stacjonarne modele PCA i ICA można zdefiniować na podstawie wspólnego modelu danych. Załóżmy, że niektóre procesy stochastyczne są reprezentowane przez trzy losowe (kolumnowe) wektory x(t), n(t) ∈ ℝN i s (t) ∈? ℝM ze średnią zerową i skończoną kowariancją, ze składowymi s(t) ={s1(t),s21(t) … sM1(t)} będąc statystycznie niezależnym i co najwyżej jednym Gaussem. Niech A będzie prostokątną stałą macierzą N × M o pełnym rzędzie kolumnowym, zawierającą co najmniej tyle wierszy, ile kolumn ( N ≥ M ), i oznacz przez t indeks próbki (tj. czas lub punkt próbkowania), przyjmując wartości dyskretne t = 1, 2, ..., T. Postulujemy istnienie liniowej zależności pomiędzy tymi zmiennymi jak:

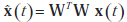

Tutaj s(t), x(t), n(t) i A są odpowiednio źródłami, obserwowanymi danymi, (nieznanym) szumem w danych i (nieznaną) macierzą mieszania, podczas gdy ai =1,2 ,..., i a i M są kolumnami A. Mieszanie ma być natychmiastowe, więc nie ma opóźnienia czasowego pomiędzy (ukrytą) zmienną źródłową si(t) i jest mieszaną w obserwowalną zmienną (danych) xj/sub>(t) , gdzie i = 1, 2, ..., M i j = 1, 2, ..., N. Rozważmy, że stochastyczny proces wektorowy {x(t)} ∈ ℝN ma średnią E{x(t)}= 0 i macierz kowariancji Cx = {x(t)x(t)T} . Celem PCA jest aby zidentyfikować strukturę zależności w każdym wymiarze i uzyskać macierz transformacji ortogonalnej W o rozmiarze L×N od ?ℝN do ?ℝL , L < N , taką, że L-wymiarowy wektor wyjściowy y(t)=W x(t) dostatecznie reprezentuje wewnętrzne cechy danych wejściowych, i gdzie macierz kowariancji Csub>y z {y (t)} jest macierzą diagonalną D z elementami diagonalnymi ułożonymi w kolejności malejącej, , di,j ≥ di+1,j+1 . Przywrócenie {x(t)} z {y(t)}, powiedzmy  , jest w konsekwencji dane wzorem

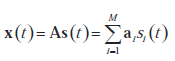

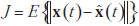

, jest w konsekwencji dane wzorem  . Dla danego L celem PCA jest znalezienie optymalnej wartości W, takiej jak minimalizacja funkcji błędu

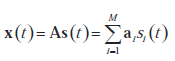

. Dla danego L celem PCA jest znalezienie optymalnej wartości W, takiej jak minimalizacja funkcji błędu  . Wiersze w W to PC procesu stochastycznego {x(t)} i wektory własne cj , 1, 2,...,L wejściowej macierzy kowariancji Cx . Podprzestrzeń rozpięta głównymi wektorami własnymi {c1,c2 …cL} gdzie L < N , nazywana jest podprzestrzenią PCA wymiarowości L. Problem ICA można sformułować następująco: przy danych T realizacjach x(t) , oszacuj zarówno macierz A, jak i odpowiadające jej realizacje s (t). W BSS zadanie jest nieco prostsze i polega na znalezieniu przebiegów {si(t} źródeł znających jedynie (obserwowane) mieszaniny {xj(t)} . Jeśli nie poczyniono żadnych założeń na temat szumu, w (1) pomija się addytywny składnik szumu. Praktyczną strategią jest włączenie szumu do sygnałów jako składnika(ów) uzupełniającego: stąd model ICA przyjmuje postać:

. Wiersze w W to PC procesu stochastycznego {x(t)} i wektory własne cj , 1, 2,...,L wejściowej macierzy kowariancji Cx . Podprzestrzeń rozpięta głównymi wektorami własnymi {c1,c2 …cL} gdzie L < N , nazywana jest podprzestrzenią PCA wymiarowości L. Problem ICA można sformułować następująco: przy danych T realizacjach x(t) , oszacuj zarówno macierz A, jak i odpowiadające jej realizacje s (t). W BSS zadanie jest nieco prostsze i polega na znalezieniu przebiegów {si(t} źródeł znających jedynie (obserwowane) mieszaniny {xj(t)} . Jeśli nie poczyniono żadnych założeń na temat szumu, w (1) pomija się addytywny składnik szumu. Praktyczną strategią jest włączenie szumu do sygnałów jako składnika(ów) uzupełniającego: stąd model ICA przyjmuje postać:

Separacja źródeł polega na aktualizacji macierzy rozmieszania B(t), bez odwoływania się do informacji o macierzy mieszania przestrzennego A, tak aby wektor wyjściowy y(t)= B(t) x(t) stał się estymatorem

Separacja źródeł polega na aktualizacji macierzy rozmieszania B(t), bez odwoływania się do informacji o macierzy mieszania przestrzennego A, tak aby wektor wyjściowy y(t)= B(t) x(t) stał się estymatorem  oryginalnych niezależnych sygnałów źródłowych s(t). Macierz rozdzielająca B(t) jest podzielona na dwie części dotyczące zależności w dwóch pierwszych momentach, tj. macierzy wybielającej V(t) oraz zależności w statystyce wyższego rzędu, tj. ortogonalnej macierzy rozdzielającej W(t) w wybielonej przestrzeni. Jeśli założymy, że obserwowane dane x(t) są zerowymi średnimi, to otrzymamy je poprzez wybielanie wektora v(t)= V(t)x(t) dekorelowanymi składnikami. Kolejna transformacja liniowa W(t) szuka rozwiązania poprzez odpowiedni obrót w przestrzeni gęstości składowych i daje y (t )=W(t ) v(t ). Całkowita macierz separacji pomiędzy warstwą wejściową i wyjściową okazuje się być B(t) =W(t) V(t). W standardowym przypadku stacjonarnym wybielanie i ortogonalne macierze separacyjne zbiegają się do pewnych stałych wartości po skończonej liczbie iteracji podczas uczenia, czyli B(t) → B = W V.

oryginalnych niezależnych sygnałów źródłowych s(t). Macierz rozdzielająca B(t) jest podzielona na dwie części dotyczące zależności w dwóch pierwszych momentach, tj. macierzy wybielającej V(t) oraz zależności w statystyce wyższego rzędu, tj. ortogonalnej macierzy rozdzielającej W(t) w wybielonej przestrzeni. Jeśli założymy, że obserwowane dane x(t) są zerowymi średnimi, to otrzymamy je poprzez wybielanie wektora v(t)= V(t)x(t) dekorelowanymi składnikami. Kolejna transformacja liniowa W(t) szuka rozwiązania poprzez odpowiedni obrót w przestrzeni gęstości składowych i daje y (t )=W(t ) v(t ). Całkowita macierz separacji pomiędzy warstwą wejściową i wyjściową okazuje się być B(t) =W(t) V(t). W standardowym przypadku stacjonarnym wybielanie i ortogonalne macierze separacyjne zbiegają się do pewnych stałych wartości po skończonej liczbie iteracji podczas uczenia, czyli B(t) → B = W V.

IMPLEMENTACJE NEURONALNE

Neuronowe podejście do BSS obejmuje sieć, która ma mieszaniny sygnałów źródłowych na wejściu i generuje przybliżone sygnały źródłowe na wyjściu (rysunek 3). Warunkiem wstępnym jest to, że sygnały wejściowe muszą być wzajemnie nieskorelowane, co jest wymogiem zwykle spełnianym przez PCA. Sygnały wyjściowe muszą jednak być od siebie niezależne, co w naturalny sposób prowadzi z PCA do ICA. Statystyki wyższego rzędu wymagane przez separację źródeł można włączyć do obliczeń bezpośrednio lub poprzez zastosowanie odpowiednich nieliniowości. SSN lepiej pasują do tego drugiego podejścia . Rdzeń dużej klasy neuronowych algorytmów adaptacyjnych składa się z reguły uczenia się i powiązanego z nią kryterium optymalizacji (funkcji celu). Te dwa elementy różnicują algorytmy, które w rzeczywistości są rodzinami algorytmów sparametryzowanych przez zastosowaną funkcję nieliniową. Reguła aktualizacji jest określona przez iteracyjną przyrostową zmianę ΔW macierzy rotacji W, co daje ogólną postać reguły uczenia się:

W → W + ΔW

Neuronowa PCA

Najpierw rozważmy pojedynczy sztuczny neuron otrzymujący M-wymiarowy wektor wejściowy x. Stopniowo dostosowuje swój wektor wag w tak, aby funkcja E{f(wTx)} była maksymalizowana, gdzie E jest oczekiwaniem w odniesieniu do (nieznanej) gęstości prawdopodobieństwa x, a f jest ciągłą funkcją celu. Funkcja f jest ograniczona przez ustawienie stałej normy euklidesowej w. Reguła uczenia się z ograniczonym gradientem wznoszenia oparta na sekwencji przykładowych funkcji dla stosunkowo małych szybkości uczenia się α(t) oznacza zatem :

w(t+1)= w(t)+a(t) (I - w(t)

gdzie g = f′ . Wszelkie reguły uczenia się PCA mają tendencję do znajdowania tego kierunku w przestrzeni wejściowej, wzdłuż którego dane mają maksymalną wariancję. Jeśli wszystkie kierunki w przestrzeni wejściowej mają równą wariancję, przypadek jednojednostkowy z odpowiednią nieliniowością w przybliżeniu minimalizuje kurtozę wejścia neuronu. Oznacza to, że wektor wag jednostki będzie wyznaczany przez kierunek w przestrzeni wejściowej, na który rzutowanie danych wejściowych jest w większości skupione i odbiega znacząco od normalności. To zadanie jest zasadniczo celem w technice PP. W przypadku jednowarstwowych sieci ANN składających się z L jednostek równoległych, przy czym każda jednostka i ma ten sam wektor wejściowy M-elementowy x i własny wektor wagowy Wi, które razem tworzą macierz wag M × L W =[w1 ,w2,… wL następująca reguła uczenia uzyskana powyżej jest uogólnieniem liniowej reguły uczenia się PCA (w postaci macierzowej):

W(t+1)= W(t)+a(t) (I - W(t)

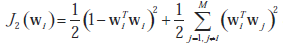

Ze względu na niestabilność powyższego nieliniowej reguły Hebbiana uczenia się dla przypadku wielu jednostek wprowadzono inne podejście polegające na jednoczesnej optymalizacji dwóch kryteriów :

W(t+1)= W(t)+μ(t)(x(t)g(y(t)T) + γ(t)(I-W(t)W(t)T))

Tutaj μ(t) jest wybierane jako dodatnie lub ujemne w zależności od tego, czy jesteśmy zainteresowani odpowiednio maksymalizacją lub minimalizacją funkcji celu J1(wi = E{f(xTwi)}. Podobnie γ(t) jest kolejnym parametrem wzmocnienia, który jest zawsze dodatni i ogranicza wektory wag do ortonormalności, która jest narzucona przez odpowiednią funkcję kary, taką jak:

Jest to algorytm bigradientu, który jest iterowany, aż wektory wag osiągną zbieżność z pożądaną dokładnością. Algorytm ten może wykorzystywać znormalizowane uczenie się Hebbiana lub anty-Hebbiana w ujednoliconej formule. Wychodząc od reguły jednej jednostki, wielojednostkowy algorytm bigradientu może jednocześnie wyodrębnić kilka solidnych odpowiedników głównych lub mniejszych wektorów własnych macierzy kowariancji danych . W przypadku wielowarstwowych SSN transfer funkcji ukrytych węzłów można wyrazić radialnymi funkcjami bazowymi (RBF), których parametrów można się nauczyć za pomocą dwustopniowej strategii opadania gradientowego. W celu poprawy wydajności netto stosowana jest nowa, rozwijająca się strategia wstawiania węzłów RBF z różnymi RBF. Podano, że strategia uczenia się oszczędza czas obliczeniowy i przestrzeń pamięci w przybliżeniu mapowań ciągłych i nieciągłych.

Neuronowy ICA

W SSN wdrożono różne formy uczenia się bez nadzoru, wykraczające poza standardowe PCA, takie jak nieliniowe PCA i ICA. Wybielanie danych może być emulowane neuronowo przez PCA za pomocą prostego algorytmu iteracyjnego, który aktualizuje macierz sferyczną V(t):

V(t+1)= V(t)-α(t)(vvT - I)

Po otrzymaniu macierzy dekorelacji V(t), podstawowym zadaniem algorytmów ICA pozostaje otrzymanie macierzy ortogonalnej W(t ), co jest równoznaczne z odpowiednią rotacją dekorelowanych danych v(t)= V(t)x(t) mające na celu maksymalizację iloczynu gęstości krańcowych jego składników. Istnieją różne podejścia neuronowe do szacowania macierzy rotacji W(t). Ważna klasa algorytmów opiera się na maksymalizacji entropii sieci. Algorytm maksymalizacji informacji nieliniowej BS (infomax) wykonuje online stochastyczne wznoszenie gradientu we wzajemnych informacjach (MI) pomiędzy wyjściami i wejściami sieci. Minimalizując MI pomiędzy wyjściami, sieć rozkłada wejścia na niezależne komponenty. Rozważenie sieci z wektorem wejściowym x(t), macierzą wag W(t) i monotonicznie przekształconym wektorem wyjściowym y=g(Wx+w0) , to wynikowa reguła uczenia się odpowiednio dla wag i wag błędu systematycznego wynosi:

ΔW= [WT]-1 + x(1? 2y)T a Δw0 = 1? 2y

W przypadku zmiennych ograniczonych wzajemne oddziaływanie członu antyhebbowskiego x(1?2y)T i członu przeciwdziałającego rozpadowi [WT]-1?? daje gęstość wyjściową bliską płaskiemu rozkładowi stałemu, który odpowiada do maksymalnego rozkładu entropii. Amari, Cichocki i Yang zmienili algorytm BS infomax, wykorzystując gradient naturalny zamiast gradientu stochastycznego, aby zmniejszyć złożoność obliczeń neuronowych i znacząco poprawić szybkość zbieżności. Reguła aktualizacji zaproponowana dla macierzy rozdzielającej to:

ΔW= [I - g(Wx) (Wx)T]W

Lee rozszerzył zarówno na rozkłady sub-, jak i supergaussowskie, regułę uczenia się opracowaną na podstawie zasady infomax spełniającą ogólne kryterium stabilności i zachowującą prosty początkową architekturę sieci. Stosując do optymalizacji gradient naturalny lub względny , ich zasada uczenia się daje wyniki, które konkurują z obliczeniami wsadowymi o stałym punkcie. Algorytm ekwiwariantnej separacji adaptacyjnej poprzez niezależność (EASI) wprowadzony przez Cardoso i Lahelda (1996) jest nieliniową metodą dekorelacji. Funkcja celu J(W)= E{f(Wx)} poddawana jest minimalizacji przy zastosowaniu ograniczenia ortogonalnego nałożonego na W i nieliniowości g = f′ wybranej według kurtozy danych. Podstawowa zasada aktualizacji jest równa:

ΔW= ?λ (yyT ? I + g (y)yT ? yg (yT ))W

Algorytmy stałoprzecinkowe (FP) przeszukują rozwiązanie ICA poprzez minimalizację wzajemnych informacji (MI) pomiędzy estymowanymi komponentami. Reguła uczenia się FastICA znajduje kierunek w taki, że rzut wTx maksymalizuje funkcję kontrastu postaci JG(w) = [E{f(wT)} - E{f(v)}]2, gdzie v oznacza standaryzowaną zmienną Gaussa. Reguła uczenia się jest w zasadzie metodą dekorelacji podobną do metody Grama-Schmidta.

OCENA ALGORYTMU

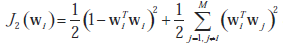

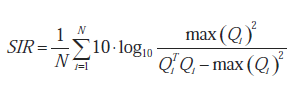

Porównawczo uruchamiamy algorytmy neuronowe PCA i ICA, korzystając z syntetycznie wygenerowanych szeregów czasowych, zepsutych addytywnie pewnym białym szumem, aby złagodzić ścisły determinizm . Od tego czasu neuronowa PCA została zaimplementowana przy użyciu algorytmu bigradient działa to zarówno w przypadku minimalizacji, jak i maksymalizacji kryterium J1 w ramach ograniczeń normalności narzuconych przez funkcję kary J2. Algorytmy neuronowe ICA obejmowały rozszerzony infomax Bella i Sejnowskiego, póładaptacyjny stałoprzecinkowy szybki algorytm ICA, zaadaptowany wariant algorytmu EASI zoptymalizowany pod kątem danych rzeczywistych oraz rozszerzony uogólniony rozkład lambda (EGLD ) algorytm oparty na maksymalnej wiarygodności. W przypadku źródeł sztucznie generowanych dokładność wyodrębnienia źródeł ukrytych przez algorytm wykonujący ICA można mierzyć za pomocą pewnych wskaźników ilościowych. Pierwszy, którego użyliśmy, został zdefiniowany jako stosunek sygnału do zakłóceń (SIR):

gdzie Q = BA jest ogólną macierzą transformacji ukrytych składników źródła, i Q jest i-tą kolumną Q, max(Qi) jest maksymalnym elementem Qi, a N jest liczbą sygnałów źródłowych. Im wyższy jest SIR, tym lepsza jest skuteczność separacji algorytmu. Drugim zastosowanym wskaźnikiem była odległość pomiędzy całkowitą macierzą transformującą Q a idealną macierzą permutacji, którą interpretuje się jako błąd przesłuchu (CTE):

Powyżej Qij jest ij-tym elementem Q, max |Qi|jest maksymalnym elementem wiersza i w Q o maksymalnej wartości bezwzględnej, a max |Qj| jest elementem kolumny j w Q o maksymalnej wartości bezwzględnej. Macierz permutacji to zdefiniowany tak, że w każdym z jego wierszy i kolumn tylko jeden z elementów jest równy jedności, podczas gdy wszystkie pozostałe elementy są równe zero. Oznacza to, że CTE osiąga minimalną wartość zero dla dokładnej macierzy permutacji (tj. doskonałego rozkładu) i wzrasta dodatnio, im bardziej Q odbiega od macierzy permutacji (tj. rozkładu o mniejszej dokładności). Zdefiniowaliśmy względny błąd wyszukiwania sygnału (SRE) jako odległość euklidesową między sygnałami źródłowymi a ich najlepiej dopasowanymi estymowanymi składowymi, znormalizowaną do liczby sygnałów źródłowych, razy liczbę próbek czasowych, i razy moduł sygnałów źródłowych:

Im niższy jest SRE, tym lepiej szacunki przybliżają ukryte sygnały źródłowe. Stabilizowana wersja algorytmu FastICA jest atrakcyjna ze względu na szybką i niezawodną zbieżność oraz brak parametrów wymagających dostrajania. Naturalny gradient zawarty w rozszerzonym infomaxie BS działa lepiej niż oryginalne wznoszenie gradientowe i jest mniej wymagający obliczeniowo. Chociaż algorytm BS jest teoretycznie optymalny w sensie traktowania wzajemnych informacji jako funkcji celu, podobnie jak wszystkie neuronowe algorytmy bez nadzoru, jego działanie w dużym stopniu zależy od szybkości uczenia się, a jego zbieżność jest raczej powolna. Algorytm EGLD oddziela rozkłady skośne, nawet dla zerowej kurtozy. Pod względem czasu obliczeń najszybszy był rozszerzony algorytm infomax BS, FastICA wierniej pobierał źródła spośród wszystkich testowanych algorytmów, natomiast algorytm EASI wyszedł z macierzą pełnej transformacji Q, która jest najbliższa jedności.

PRZYSZŁE TRENDY

Metody neuromorficzne w analizie eksploracyjnej i eksploracji danych to szybko pojawiające się zastosowania nienadzorowanego treningu neuronowego. W ostatnich latach zaproponowano nowe algorytmy uczenia się, jednak ich właściwości teoretyczne, zakres optymalnego zastosowania i ocena porównawcza pozostają w dużej mierze niezbadane. Z używanymi algorytmami uczącymi nie są powiązane żadne twierdzenia o zbieżności. Co więcej, zbieżność algorytmów w dużym stopniu zależy od właściwego wyboru szybkości uczenia się i nawet po osiągnięciu zbieżności algorytmy neuronowe są stosunkowo powolne w porównaniu z obliczeniami typu wsadowego. Oczekuje się, że nieliniowy i niestacjonarny neuronowy ICA zostanie opracowany dzięki niealgorytmicznemu przetwarzaniu SSN i ich zdolności do uczenia się relacji nieanalitycznych, jeśli zostaną odpowiednio przeszkolone.

WNIOSEK

Zarówno PCA, jak i ICA mają pewne wspólne cechy, takie jak skupienie się na budowaniu modeli generatywnych, które prawdopodobnie wygenerowały zaobserwowane dane, oraz zachowanie informacji i redukcja redundancji. W podejściu neuromorficznym parametry modelu traktowane są jako wagi sieci, które zmieniają się w procesie uczenia. Główna trudność w aproksymacji funkcji wynika z wyboru parametrów sieci, które należy ustalić a priori oraz tych, których należy się nauczyć za pomocą odpowiedniej reguły szkoleniowej. PCA i ICA mają główne zastosowania w eksploracji danych i eksploracyjnej analizie danych, takich jak charakterystyka sygnału, ekstrakcja optymalnych cech i kompresja danych, a także stanowią podstawę klasyfikatorów podprzestrzennych w rozpoznawaniu wzorców. ICA jest znacznie lepiej dopasowana niż PCA do wykonywania BSS, ślepej dekonwolucji i wyrównywania.

Logika rozmyta stała się podstawą innego podejścia do informatyki. Podczas gdy tradycyjne podejścia do obliczeń były precyzyjne lub miały twarde krawędzie, logika rozmyta umożliwiła zastosowanie mniej precyzyjnego lub bardziej miękkiego podejścia. Podejście, w którym precyzja nie jest najważniejsza, jest nie tylko bliższe sposobowi myślenia człowieka, ale w rzeczywistości może być również łatwiejsze do stworzenia. W ten sposób narodziła się dziedzina miękkiego przetwarzania danych. Do tej dziedziny dodano inne techniki, takie jak sztuczne sieci neuronowe (ANN) i algorytmy genetyczne, oba wzorowane na układach biologicznych. Wkrótce zdano sobie sprawę, że narzędzia te można połączyć i mieszając je ze sobą, mogą zakryć swoje słabe strony, a jednocześnie wygenerować coś, co jest większe niż jego części, czyli krótko mówiąc, tworząc synergię. Adaptacyjny Neuro-fuzzy jest prawdopodobnie najbardziej znaną z tych domieszek miękkich technologii obliczeniowych. Technika ta powstała po zmodyfikowaniu sztucznych sieci neuronowych do pracy z logiką rozmytą, stąd nazwa Neuro-fuzzy . To połączenie zapewnia systemom rozmytym zdolność adaptacji i uczenia się. Później wykazano, że adaptacyjne systemy rozmyte można tworzyć przy użyciu innych technik obliczeń miękkich, takich jak algorytmy genetyczne , zbiory przybliżone i sieci Bayesa , ale powszechnie używana była nazwa Neuro-fuzzy, więc pozostała. Neuro-fuzzy to ogólny opis szerokiej gamy narzędzi i technik używanych do łączenia dowolnego aspektu logiki rozmytej z dowolnym aspektem sztucznych sieci neuronowych. W większości te kombinacje są po prostu rozszerzeniami jednej lub drugiej technologii. Na przykład sieci neuronowe zwykle przyjmują dane wejściowe binarne, ale używają wag o różnej wartości od 0 do 1. Dodawanie zbiorów rozmytych do SSN w celu przekształcenia zakresu wartości wejściowych na wartości, które można wykorzystać jako wagi, jest uważane za rozwiązanie neurorozmyte. Szczególne zainteresowanie zwrócimy na poddziedzinę, w której reguły logiki rozmytej są modyfikowane przez adaptacyjny aspekt systemu. Następna część będzie zorganizowana w następujący sposób: w części 1 przyjrzymy się modelom i technikom używanym do łączenia logiki rozmytej i sieci neuronowych w celu stworzenia systemów neuro-rozmytych. Sekcja 2 zawiera przegląd głównych etapów rozwoju adaptacyjnych systemów neuro-rozmytych. Sekcja 3 kończy się pewnymi zaleceniami i przyszłymi zmianami.

TECHNOLOGIA NEURO-FUZZY

Technologia neuro-fuzzy to szeroki termin używany do opisania dziedziny technik i metod stosowanych do łączenia logiki rozmytej i sieci neuronowych . Logika rozmyta i sieci neuronowe mają swój własny zestaw mocnych i słabych stron, a większość prób połączenia tych dwóch technologii ma na celu wykorzystanie mocnych stron każdej z technik w celu zakrycia słabości pozostałych. Sieci neuronowe mają zdolność samouczenia się, klasyfikacji i kojarzenia danych wejściowych z wynikami. Sieci neuronowe mogą stać się także uniwersalnym aproksymatorem funkcji. Mając wystarczającą ilość informacji o nieznanej funkcji ciągłej, takich jak jej wejścia i wyjścia, sieć neuronową można wytrenować, aby ją aproksymowała. Wadą sieci neuronowych jest to, że nie gwarantują ich zbieżności, czyli prawidłowego wyszkolenia, a po przeszkoleniu nie mogą podać żadnych informacji o tym, dlaczego podejmują określony sposób działania, gdy otrzymają określone dane wejściowe. Logika rozmyta Systemy wnioskowania mogą dostarczyć czytelnych i zrozumiałych dla człowieka informacji o tym, dlaczego podjęto określony sposób działania, ponieważ jest on regulowany przez szereg reguł JEŻELI TO. Systemy logiki rozmytej można dostosować w taki sposób, że ich reguły i parametry zbiorów rozmytych powiązanych z tymi regułami można zmieniać, aby spełnić pewne kryteria. Jednak systemy logiki rozmytej nie mają zdolności do samouczenia się i muszą być modyfikowane przez podmiot zewnętrzny. Inną istotną cechą systemów logiki rozmytej jest to, że podobnie jak sztuczne sieci neuronowe mogą one działać jako uniwersalne aproksymatory. Wspólna cecha możliwości działania jako uniwersalny aproksymator jest podstawą większości prób połączenia tych dwóch technologii. Można go używać nie tylko do aproksymacji funkcji, ale może być również używany zarówno przez sieci neuronowe, jak i systemy logiki rozmytej do wzajemnego aproksymacji. Przybliżenie uniwersalne to zdolność systemu do pewnego stopnia replikowania funkcji. Zarówno sieci neuronowe, jak i systemy logiki rozmytej robią to poprzez wykorzystanie niematematycznego modelu systemu. Używa się terminu przybliżony, ponieważ model nie musi dokładnie odpowiadać symulowanej funkcji, chociaż czasami jest to możliwe, jeśli dostępna jest wystarczająca ilość informacji o funkcji. W większości przypadków doskonała symulacja funkcji nie jest konieczna ani nawet pożądana, ponieważ wymaga czasu i zasobów, które mogą nie być dostępne, a zamknięcie często jest wystarczające.

Kategorie systemów neurorozmytych

Próby połączenia logiki rozmytej i sieci neuronowych trwają od kilku lat i wypróbowano i wdrożono wiele metod. Metody te dzielą się na dwie główne kategorie:

• Fuzzy Neural Networks (FNN): to sieci neuronowe, które mogą wykorzystywać rozmyte dane, takie jak rozmyte reguły, zbiory i wartości .

• Systemy rozmyte neuronowe (NFS): to systemy rozmyte "wzmacniane" przez sieci neuronowe .

Istnieją również cztery główne architektury stosowane do wdrażania systemów neuro-rozmytych:

• Rozmyte sieci wielowarstwowe.

• Rozmyte sieci samoorganizujących się map

• Black-Box Fuzzy ANN

• Architektury hybrydowe.

ROZWÓJ ADAPTACYJNYCH SYSTEMÓW NEURO-ROZMYTYCH

Opracowywanie adaptacyjnego systemu neuro-rozmytego to proces podobny do procedur stosowanych przy tworzeniu systemów logiki rozmytej i sieci neuronowych. Zaletą tego łączonego podejścia jest to, że zwykle nie jest ono bardziej skomplikowane niż każde podejście stosowane indywidualnie. Jak zauważono powyżej, istnieją dwie metody tworzenia systemu neurorozmytego; integrowanie logiki rozmytej ze strukturą sieci neuronowej (FNN) i wdrażanie sieci neuronowych w system logiki rozmytej (NFS). Rozmyta sieć neuronowa to po prostu sieć neuronowa z pewnymi elementami logiki rozmytej; dlatego jest ogólnie szkolony jak normalna sieć neuronowa. Proces szkoleniowy: Schemat szkolenia dla NFS różni się nieco od schematu stosowanego do tworzenia sieci neuronowej i systemu logiki rozmytej pod pewnymi kluczowymi względami, a jednocześnie zawiera wiele ulepszeń w porównaniu z tymi metodami szkoleniowymi. Proces uczenia systemu neurorozmytego składa się z pięciu głównych etapów:

• Uzyskaj dane szkoleniowe: Dane muszą obejmować wszystkie możliwe wejścia i wyjścia oraz wszystkie krytyczne obszary funkcji, jeśli mają być modelowane w odpowiedni sposób

• Utwórz system logiki rozmytej: systemem rozmytym może być istniejący system, o którym wiadomo, że działa, na przykład taki, który jest w produkcji od jakiegoś czasu lub taki, który został stworzony zgodnie z metodologią opracowywania systemów eksperckich.

• Zdefiniuj neuronowe uczenie się rozmyte: Ta faza dotyczy definiowania tego, czego system ma się uczyć. Pozwala to na większą kontrolę nad procesem uczenia się, jednocześnie umożliwiając odkrywanie wiedzy o regułach.

• Faza treningu: Aby uruchomić algorytm uczenia. Algorytm może posiadać parametry, które można regulować w celu modyfikacji sposobu modyfikacji systemu podczas uczenia.

• Optymalizacja i weryfikacja: Walidacja może przybierać różne formy, ale zazwyczaj obejmuje dostarczenie do systemu serii znanych danych wejściowych w celu ustalenia, czy system generuje żądany wynik i/lub mieści się w akceptowalnych parametrach. Co więcej, można wyodrębnić reguły i funkcje członkostwa, aby eksperci mogli je sprawdzić pod kątem poprawności

WNIOSKI I PRZYSZŁY ROZWÓJ

Zalety systemów ANF: Chociaż istnieje wiele sposobów wdrożenia systemu Neuro-fuzzy, zalety opisane dla tych systemów są niezwykle jednolite w całej literaturze. Zalety przypisywane systemom neuro-rozmytym w porównaniu z SSN są zwykle związane z następującymi aspektami:

• Szybsze uczenie: wynika to z ogromnej liczby połączeń występujących w sieci SSN i nietrywialnej liczby obliczeń związanych z każdym z nich. Ponadto większość rozmytych systemów neuronowych można trenować, przeglądając dane raz, podczas gdy sieć neuronowa może wymagać wielokrotnego wystawienia na działanie tych samych danych uczących, zanim osiągną one zbieżność.

• Mniej zasobów obliczeniowych: Rozmyty system neuronowy jest mniejszy i zawiera mniej połączeń wewnętrznych niż porównywalna sieć SSN, dlatego jest szybszy i zużywa znacznie mniej zasobów.

• Oferują możliwość wyodrębnienia reguł: Jest to główna zaleta w porównaniu z SSN, ponieważ zasady regulujące system mogą być przekazywane użytkownikom w łatwo zrozumiałej formie.

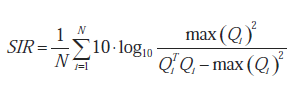

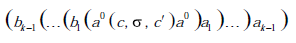

Ograniczenia systemów ANF: Największe ograniczenie w tworzeniu systemów adaptacyjnych znane jest jako "Klątwa Wymiarowości", której nazwa wzięła się od wykładniczego wzrostu liczby cech, które model musi śledzić w miarę wzrostu liczby atrybutów wejściowych. Każdy atrybut w modelu jest zmienną w systemie, która odpowiada osi na wielowymiarowym wykresie, na którą odwzorowywana jest funkcja. Powiązania pomiędzy różnymi atrybutami odpowiadają liczbie potencjalnych reguł w systemie, określonej wzorem:

Nrules = (Llinguistic_terms)variables