https://aie24.pl/

Python to najpopularniejszy język do zadań związanych z analizą danych i uczeniem maszynowym. W porównaniu z konwencjonalnymi językami programowania do nauki o danych, takimi jak R i Stata, Python wyróżnia się, ponieważ jest skalowalny i dobrze integruje się z bazami danych. Jest szeroko stosowany i ma kwitnącą społeczność programistów, którzy aktualizują swój ekosystem. Python jest łatwy do nauczenia i zawiera przydatne biblioteki do nauki o danych, takie jak NumPy i pandy. Możesz sparować GPT-3 z Pythonem, korzystając z biblioteki o nazwie Chronology, która zapewnia prosty i intuicyjny interfejs. Chronologia może złagodzić monotonną pracę polegającą na pisaniu całego kodu od zera za każdym razem. Jego funkcje obejmują:

* Wywołuje asynchronicznie interfejs API OpenAI, umożliwiając generowanie

wiele szybkich uzupełnień w tym samym czasie.

* Możesz łatwo tworzyć i modyfikować podpowiedzi szkoleniowe; na przykład modyfikowanie podpowiedzi szkoleniowej używanej w innym przykładzie jest dość proste.

* Umożliwia łączenie podpowiedzi poprzez podłączenie wyjścia jednego podpowiedzi do drugiego.

Chronologia jest hostowana na PyPI i obsługuje Python 3.6 i nowsze wersje. Aby zainstalować bibliotekę, uruchom następującą komendę:

pip install chronological

Po zainstalowaniu biblioteki Pythona przez PyPI przyjrzyjmy się przykładowi, jak przygotować GPT-3, aby podsumował dany dokument tekstowy na poziomie czytania drugiej klasy. Pokażemy Ci, jak wywołać interfejs API, wysłać monit szkoleniowy jako żądanie i uzyskać podsumowanie zakończenia w postaci wyniku. Opublikowaliśmy kod dla Ciebie w repozytorium GitHub. W tym przykładzie użyjemy następującego podpowiedzi szkoleniowej:

Moja uczennica drugiej klasy zapytała mnie, co oznacza ten fragment:

„””

Oliwa z oliwek to płynny tłuszcz otrzymywany z oliwek (owoców Olea

europaea;

rodzina Oleaceae)…

„””

Przeformułowałem to za niego, prostym językiem, jaki potrafi drugoklasista

zrozumieć:

„””

Najpierw zaimportuj następujące zależności:

# Importing Dependencies

from chronological import read_prompt, cleaned_completion, main

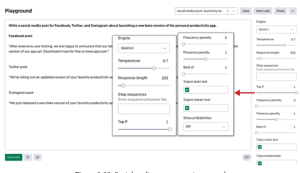

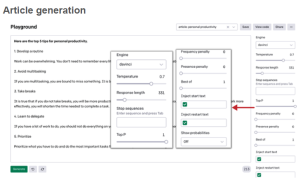

z importu chronologicznego read_prompt, clean_completion, main Teraz możemy stworzyć funkcję, która odczyta zachętę do szkolenia i wyświetli wynik zakończenia. Uczyniliśmy tę funkcję asynchroniczną, co pozwala nam na wykonywanie równoległych wywołań funkcji. Dla parametrów API zastosujemy następującą konfigurację:

Maksymalna liczba tokenów=100

Silnik wykonawczy = „Davinci”

Temperatura=0,5

Top-p=1

Kara za częstotliwość = 0,2

Sekwencja zatrzymania=[„\n\n”]

# Przyjmuje komunikat szkoleniowy i zwraca pełną odpowiedź

async def podsumowanie_przykład():

# Jako dane wejściowe pobiera plik tekstowy (summarize_for_a_2nd_grader).

podpowiedź

Prompt_summarize = read_prompt(‘podsumowanie_dla_2.klasisty’)

# Wywołanie metody uzupełniania wraz z konkretnym GPT-3

parametry

kompletacja_summarize = czekaj

clean_completion(prompt_summarize,

max_tokens=100, silnik=”davinci”, temperatura=0,5, top_p=1,

częstotliwość_kara=0,2, stop=[“\n\n”])

# Zwróć odpowiedź o zakończeniu

zwróć zakończenie_podsumowania

Teraz możemy stworzyć asynchroniczny przepływ pracy, wywołać go za pomocą głównej funkcji dostarczonej przez bibliotekę i wydrukować wynik w konsoli:

# Projektowanie kompleksowego, asynchronicznego przepływu pracy, który można uruchomić

wiele podpowiedzi

# równolegle

asynchroniczny przepływ pracy def():

# Wykonywanie asynchronicznego wywołania funkcji podsumowującej

text_summ_example = oczekuj podsumowania_example()

# Drukowanie wyniku w konsoli

wydrukować(‘————————-‘)

print(‘Podstawowa przykładowa odpowiedź: {0}’.format(text_summ_example))

wydrukować(‘————————-‘)

# wywołaj Chronologię, używając funkcji main do uruchomienia asynchronizacji

przepływ pracy

główny (przebieg pracy)

Zapisz go jako skrypt Pythona o nazwie text_summarization.py i uruchom go z

terminal do generowania danych wyjściowych. Możesz uruchomić następujące polecenie z

twój folder główny:

python text_summarization.py

Po wykonaniu skryptu konsola powinna wydrukować następujące podsumowanie

monitu:

————————-

Podstawowy przykład odpowiedzi: Oliwa z oliwek to płynny tłuszcz, z którego pochodzi

oliwki.

Oliwki rosną na drzewie zwanym drzewem oliwnym. Drzewo oliwne to

najczęściej

drzewo w Morzu Śródziemnym. Ludzie używają oleju do gotowania i nakładania

na ich

sałatek i jako paliwo do lamp.

————————-

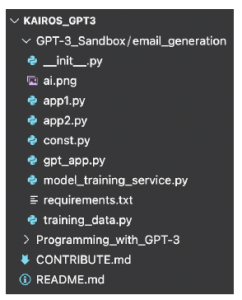

Jeśli nie jesteś dobrze zaznajomiony z językiem Python i chcesz połączyć różne podpowiedzi bez pisania kodu, możesz użyć interfejsu bez kodu wbudowanego w bibliotekę Chronology, aby utworzyć przepływ pracy podpowiedzi za pomocą metody „przeciągnij i upuść”. Więcej przykładów wykorzystania programowania w Pythonie do interakcji z GPT-3 znajdziesz w naszym repozytorium GitHub.